大语言模型依旧能够实现进一步突破,OpenAI 又一次证明了自身的强大实力。

在北京时间 9 月 13 日的午夜时分,OpenAI 郑重地公开了一系列崭新的 AI 大模型,其目的在于专门攻克难题。这无疑是一次重大的突破,新的模型能够进行复杂的推理,一个通用的模型可以解决比之前的科学、代码以及数学模型所能做到的更为困难的问题。

OpenAI 表示,今日在 ChatGPT 和大模型 API 中全新发布的乃是该系列里的首个模型,并且仅仅是预览版 ——o1-preview。除了 o1 之外,OpenAI 还展示了当下正在进行开发的下次更新的评估情况。

o1 模型瞬间创造了众多历史纪录。

首先,o1 便是此前 OpenAI 从山姆・奥特曼到科学家们一直 “大力宣扬” 的草莓大模型。它具备真正的通用推理能力。在一系列高难度基准测试当中展现出了极为强大的实力,与 GPT-4o 相比有了巨大的提升,使得大模型的上限从 “不堪入目” 直接跃升到优秀水平,无需专门训练就能直接在数学奥赛中获得金牌,甚至能够在博士级别的科学问答环节超越人类专家。

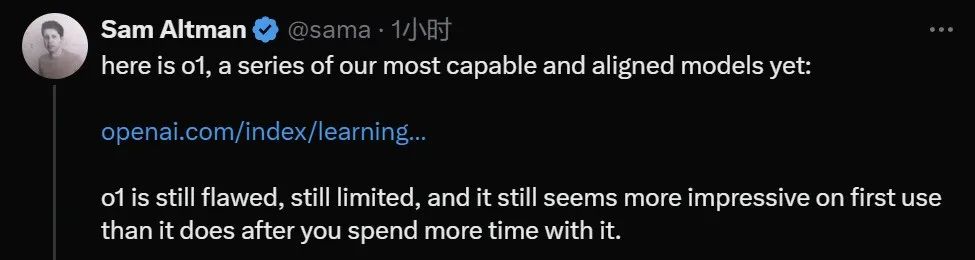

奥特曼称,尽管 o1 的表现依旧存有不足之处,但是当你首次使用它的时候,依旧会感到无比震撼。

其次,o1 使得大模型规模扩展与性能的曲线出现了一次上扬。它在大模型领域重现了当年 AlphaGo 强化学习的成功 —— 给予越多的算力,就能够输出越多的智能,一直到超越人类的水平。

也就是说,从方法层面来看,o1 大模型首次证实了语言模型能够进行真正的强化学习。

开发出首个 AI 软件工程师 Devin 的 Cognition AI 宣称,在过去的几周时间里一直与 OpenAI 紧密合作,利用 Devin 去评估 o1 的推理能力。最终发现,和 GPT-4o 相比较,o1 系列模型对于处理代码的智能体系统而言是一次重大的进步。

最后,在实际应用中,自 o1 上线以来,如今的 ChatGPT 能够在回答问题之前先进行仔细思考,而不再是立即不假思索地给出答案。如同人类大脑的系统 1 和系统 2 一样,ChatGPT 已经从仅仅使用系统 1(快速、自动、直观但容易出错)发展到可以运用系统 2 思维(缓慢、深思熟虑、有意识且可靠)。这使得它能够解决以往无法解决的问题。

从当下 ChatGPT 的用户使用体验来看,这只是向前迈进了一小步。在简单的提示下,用户或许不会察觉到太大的不同,但若是询问一些棘手的数学或者代码问题,差别就开始变得明显了。更为重要的是,未来的发展道路已经开始展露出来。

总之,今晚 OpenAI 抛出的这个重磅消息,着实让整个 AI 社区深感震撼,众人纷纷赞叹 “太厉害了”、“睡不着觉”,深夜便开始抓紧学习。接下来,就让我们一同来看看 OpenAI o1 大模型的技术细节吧。

OpenAI o1 工作原理

在技术博客《Learning to Reason with LLMs》里,OpenAI 针对 o1 系列语言模型进行了详尽的技术阐述。

OpenAI o1 属于经过强化学习训练从而能够执行复杂推理任务的新型语言模型。其特点在于,o1 在给出回答之前会进行思考 —— 它能够在回应用户之前生成一条很长的内部思维链。

也就是说,该模型在做出反应之前,需要如同人类一般,花费更多的时间去思考问题。通过训练,它们学会了完善自身的思维过程,尝试不同的策略,并且能够认识到自己的错误。

在 OpenAI 的测试当中,该系列后续更新的模型在物理、化学以及生物学这些极具挑战性的基准任务上的表现与博士生相近。OpenAI 还发觉它在数学和编码方面表现优异。

在国际数学奥林匹克(IMO)资格考试里,GPT-4o 仅仅正确解答了 13% 的问题,然而 o1 模型却正确解答了 83% 的问题。

模型的编码能力也在比赛中得到了评估,在 Codeforces 比赛中排名达到 89%。

OpenAI 表明,作为早期模型,它尚不具备 ChatGPT 的众多实用功能,例如浏览网页获取信息以及上传文件和图片。

但是对于复杂的推理任务而言,这是一个重大的进步,代表了人工智能能力的新高度。鉴于此,OpenAI 将计数器重新设置为 1,并将该系列模型命名为 OpenAI o1。

重点在于,OpenAI 的大规模强化学习算法,教会了模型如何在数据高度有效的训练过程中利用其思想链进行高效思考。换言之,类似于强化学习的 Scaling Law。

OpenAI 发现,随着更多的强化学习(训练时的计算)以及更多的思考时间(测试时的计算),o1 的性能持续提升。而且扩展这种方法的限制与大模型预训练的限制有很大的不同,OpenAI 也仍在继续进行研究。

评估

为了彰显相较于 GPT-4o 在推理性能方面的提升,OpenAI 在一系列各不相同的人类考试以及机器学习基准测试当中对 o1 模型进行了测试。实验的结果显示,在绝大多数的推理任务里,o1 的表现显著强于 GPT-4o。

o1 在具有挑战性的推理基准上比 GPT-4o 有了很大的改进。

o1 在广泛的基准测试上比 GPT-4o 有所改进,包括 54/57 MMLU 子类别,图示出了 7 个以供说明。

在众多推理密集型的基准测试当中,o1 的表现能够与人类专家相媲美。近期的前沿模型在 MATH 和 GSM8K 上的表现极为出色,以至于这些基准测试在区分模型方面已经不再有效了。所以,OpenAI 在 AIME 上对数学成绩进行了评估,AIME 是一项旨在测试美国最为聪明的高中数学学生的考试。

在一个官方演示中,o1-preview 解答了一个非常困难的推理问题:当公主的年龄是王子的两倍时,公主的年龄与王子一样大,而公主的年龄是他们现在年龄总和的一半。王子和公主的年龄是多少?提供这个问题的所有解。

在 2024 年的 AIME 考试当中,GPT-4o 平均仅仅解决了 12%(1.8/15)的问题,然而 o1 在每个问题只有一个样本的情况下平均达到了 74%(11.1/15),在 64 个样本之间达成一致的情况下为 83%(12.5/15),在使用学习的评分函数对 1000 个样本重新排序时为 93%(13.9/15)。13.9 分能够跻身全美前 500 名,并且高于美国数学奥林匹克竞赛的分数线。

OpenAI 还在 GPQA Diamond 基准上对 o1 进行了评估,这是一个艰难的智力基准,用于测试化学、物理以及生物学方面的专业知识。为了将模型与人类进行比较,OpenAI 聘请了拥有博士学位的专家来回答 GPQA Diamond 基准问题。

实验结果显示:o1 超越了人类专家的表现,成为首个在该基准测试中做到这一点的模型。

这些结果并不意味着 o1 在所有方面都比博士更有能力 —— 仅仅是该模型在解决一些博士应该解决的问题上更加擅长。在其他几个 ML 基准测试中,o1 实现了新的最高水平。

启用视觉感知能力后,o1 在 MMMU 基准上的得分为 78.2%,成为第一个与人类专家相当的模型。o1 还在 57 个 MMLU 子类别中的 54 个上优于 GPT-4o。

思维链(CoT)

和人类在回答难题之前会进行长时间思考类似,o1 在尝试解决问题的时候会运用思维链。通过强化学习,o1 学会了打磨其思维链并改进其使用的策略。o1 学会了识别并纠正错误,并且可以将棘手的步骤分解为更为简单的步骤。o1 还学会了在当前方法不起作用的时候尝试不同的方法。这个过程极大地提高了模型的推理能力。

编程能力

基于 o1 进行初始化并进一步训练了其编程技能后,OpenAI 训练得到了一个极为强大的编程模型(o1-ioi)。该模型在 2024 年国际信息学奥林匹克竞赛(IOI)赛题上获得了 213 分,达到了排名前 49% 的水平。并且该模型参与竞赛的条件与 2024 IOI 的人类参赛者相同:需要在 10 个小时内解答 6 个高难度算法问题,并且每个问题仅能提交 50 次答案。

针对每个问题,这个经过专门训练的 o1 模型会采样许多候选答案,然后基于一个测试时选取策略提交其中 50 个答案。选取标准包括在 IOI 公共测试案例、模型生成的测试案例以及一个学习得到的评分函数上的性能。

研究表明,这个策略是有效的。因为如果直接随机提交一个答案,那么平均得分仅有 156。这说明在该竞赛条件下,这个策略至少值 60 分。

OpenAI 发现,如果放宽提交限制条件,那么模型性能更是能够大幅提升。如果每个问题允许提交 1 万次答案,即使不使用上述测试时选取策略,该模型也能得到 362.14 分 —— 可以获得金牌了。

最后,OpenAI 模拟了 Codeforces 主办的竞争性编程竞赛,以展示该模型的编码技能。采用的评估与竞赛规则非常接近,允许提交 10 份代码。GPT-4o 的 Elo 评分为 808,在人类竞争对手中处于前 11% 的水平。该模型远远超过了 GPT-4o 和 o1—— 它的 Elo 评分为 1807,表现优于 93% 的竞争对手。

在编程竞赛上进一步微调使得 o1 能力又增,并在 2024 年国际信息学奥林匹克竞赛(IOI)规则下排名前 49%。

下面这个官方的示例非常直观地展现了 o1-preview 的编程能力:仅仅一段提示词就使得它写出了一个完整且能够运行的游戏。

人类偏好评估

除开考试以及学术基准之外,OpenAI 还在更多领域那些具有挑战性的开放式提示方面评估了人类对于 o1-preview 以及 GPT-4o 的偏好情况。

在此次评估当中,人类训练者对 o1-preview 和 GPT-4o 的提示进行匿名作答,并且投票选出他们更为喜欢的回答。在数据分析、编程以及数学等推理能力比较强的类别当中,o1-preview 的受欢迎程度大大高于 GPT-4o。不过,o1-preview 在某些自然语言任务方面并不受青睐,这表明它并非适用于所有的用例。

在需要更强大推理能力的领域,人们更青睐 o1-preview。

安全

思维链(CoT)推理为安全和对齐提供了全新的途径。OpenAI 察觉到,把模型行为策略融入到推理模型的思维链当中,可以高效且稳健地向人类传授价值观和原则。通过向模型教导自身的安全规则以及怎样在上下文中对它们进行推理,OpenAI 发现了推理能力直接有益于模型稳健性的证据:o1-preview 在关键越狱评估以及用于评估模型安全拒绝边界的最为严格的内部基准上取得了显著的提升。

OpenAI 觉得,运用思维链能够为安全和对齐带来重大的进展,原因在于 1)它能够以清晰的方式观察模型的思维,并且 2)关于安全规则的模型推理对于分布外场景更具稳健性。

为了对自身的改进进行压力测试,OpenAI 在部署之前依照自己的安全准备框架进行了一系列的安全测试和红队测试。结果表明,思维链推理有助于在整个评估过程中提升能力。尤其值得注意的是,OpenAI 观察到了有趣的奖励黑客攻击实例。

安全准备框架链接:https://openai.com/safety/

隐藏思维链

OpenAI 觉得隐藏思维链给监控模型提供了独特的契机。假如它是忠实且清晰的,那么隐藏思维链就能够让人们 “读懂” 模型的思想并了解其思维的过程。比如,未来人们可能会期望监控思维链以寻找操控用户的迹象。

但是要实现这一点,模型必须能够自由地以未改变的形式表达自己的思想,所以不能在思维链方面进行任何政策合规性或用户偏好性的训练。OpenAI 也不希望用户直接看到不一致的思维链。

所以,在权衡用户体验、竞争优势以及追求思维链监控的选项等多种因素之后,OpenAI 决定不向用户展示原始的思维链。OpenAI 承认这个决定有不足之处,因此努力通过教导模型在答案中重现思维链中的任何有用想法来进行部分弥补。同时,对于 o1 模型系列,OpenAI 展示了模型生成的思维链摘要。

可以说,o1 极大地提升了 AI 推理的最新水平。OpenAI 计划在不断迭代的过程中发布这个模型的改进版本,并期望这些新的推理能力能够提高将模型与人类价值观和原则相结合的能力。OpenAI 相信 o1 及其后续产品将会在科学、编程、数学以及相关领域为 AI 解锁更多新的用例。

OpenAI o1-mini

o1 属于一个系列的模型。此次,OpenAI 还一同发布了一个迷你版的 OpenAI o1-mini。该公司在博客当中给出了 preview 和 mini 版的不同界定:“为了给开发者提供更为高效的解决方案,我们也推出了 OpenAI o1-mini,这是一个尤其擅长编程的速度更快、价格更便宜的推理模型。” 总体来看,o1-mini 的成本要比 o1-preview 低百分之八十。

因为 o1 等大型语言模型是在大量的文本数据集上进行预训练的,虽然拥有广泛的世界知识,但是对于实际的应用而言,或许成本较高且速度缓慢。

与之不同的是,o1-mini 是一个较小的模型,在预训练的期间针对 STEM 推理进行了优化。在经过与 o1 相同的高计算强化学习(RL)流程进行训练之后,o1-mini 在许多有用的推理任务上实现了可相媲美的性能,同时成本效率有了显著的提高。

例如在需要智能和推理的基准测试当中,与 o1-preview 和 o1 相比,o1-mini 表现出色。但是它在需要非 STEM 事实知识的任务上表现欠佳。

数学能力方面:在高中 AIME 数学竞赛里,o1-mini(70.0%)与 o1(74.4%)表现相当,然而价格却低了很多,同时还优于 o1-preview(44.6%)。o1-mini 的得分(大概 11/15 个问题)差不多处于美国前 500 名高中生的水平。

编码能力方面:在 Codeforces 竞赛网站上,o1-mini 的 Elo 得分为 1650,与 o1(1673)相差无几,并且高于 o1-preview(1258)。另外,o1-mini 在 HumanEval 编码基准以及高中网络安全夺旗挑战(CTF)当中也有着出色的表现。

STEM 方面:在一些需要进行推理的学术基准上,就像 GPQA(科学)和 MATH-500,o1-mini 的表现要比 GPT-4o 更好。不过,o1-mini 在 MMLU 等任务上的表现不及 GPT-4o,并且由于缺少广泛的世界知识,所以在 GPQA 基准上落后于 o1-preview。

人类偏好评估:OpenAI 让人类评分员在各个领域具有挑战性的开放式提示上比较 o1-mini 和 GPT-4o。与 o1-preview 类似,在推理密集型领域,o1-mini 比 GPT-4o 更受欢迎;但在以语言为中心的领域,o1-mini 并不比 GPT-4o 更受欢迎。人类偏好评估方面:OpenAI 安排人类评分员在各个不同领域的具有挑战性的开放式提示上对 o1-mini 和 GPT-4o 进行比较。和 o1-preview 情况类似,在推理密集型的领域当中,o1-mini 比 GPT-4o 更受青睐;然而在以语言为核心的领域里,o1-mini 并不比 GPT-4o 更受欢迎。

从速度方面来看,OpenAI 对 GPT-4o、o1-mini 以及 o1-preview 在一个单词推理问题上的回答进行了比较。最终结果表明,GPT-4o 的回答是错误的,而 o1-mini 和 o1-preview 的回答都是正确的,并且 o1-mini 得出答案的速度要比它们快大约 3 到 5 倍。

如何使用 OpenAI o1?

ChatGPT Plus 以及 Team(个人付费版和团队版)的用户很快就能够在该公司的聊天机器人产品 ChatGPT 当中开始运用 o1 模型了。你能够手动去选择使用 o1-preview 或者是 o1-mini。但是呢,用户的使用量是有限制的。

当前,每位用户每周仅仅可以向 o1-preview 发送 30 条消息,向 o1-mini 发送 50 条消息。

确实,数量很少!不过 OpenAI 宣称正在尽力提高用户的可使用次数,并且让 ChatGPT 可以自动针对给定的提示词去选择使用合适的模型。

对于企业版和教育版的用户而言,要等到下周才能够开始使用这两个模型。

而对于通过 API 进行访问的用户,OpenAI 表示那些达到了 5 级 API 使用量的开发者能够马上开始使用这两个模型来开发应用原型,不过同样也被限制了速度:20 RPM。那么什么是 5 级 API 使用量呢?简单来讲,就是已经消费了 1000 美元以上并且成为付费用户超过 1 个月的情况。请查看下图。

OpenAI 表示对这两个模型的 API 调用并不包含函数调用、流式传输(streaming)、系统支持消息等功能。同样,OpenAI 表示正在努力提升这些限制。

未来

OpenAI 表示,未来除了模型更新之外,还将增加网络浏览、文件和图像上传等功能,以让这些模型变得更加有用。

「除了新的 o1 系列模型,我们计划继续开发和发布我们的 GPT 系列模型。」

参考内容:

https://openai.com/index/introducing-openai-o1-preview/

https://openai.com/index/openai-o1-mini-advancing-cost-efficient-reasoning/

https://openai.com/index/learning-to-reason-with-llms/

https://x.com/sama/status/1834283100639297910

本文链接:https://yunguke.com/chatgpt/398.html

OpenAI-o1OpenAI o1OpenAI01chatgpt o1o1-minio1-previewOpenAI o1 miniOpenAI o1 previewOpenAI o1官网OpenAI o1官网入口OpenAI o1地址OpenAI o1中文版openai o1模型简介

网友评论